YouTubeで学べる自然言語処理〜BERTを中心に〜

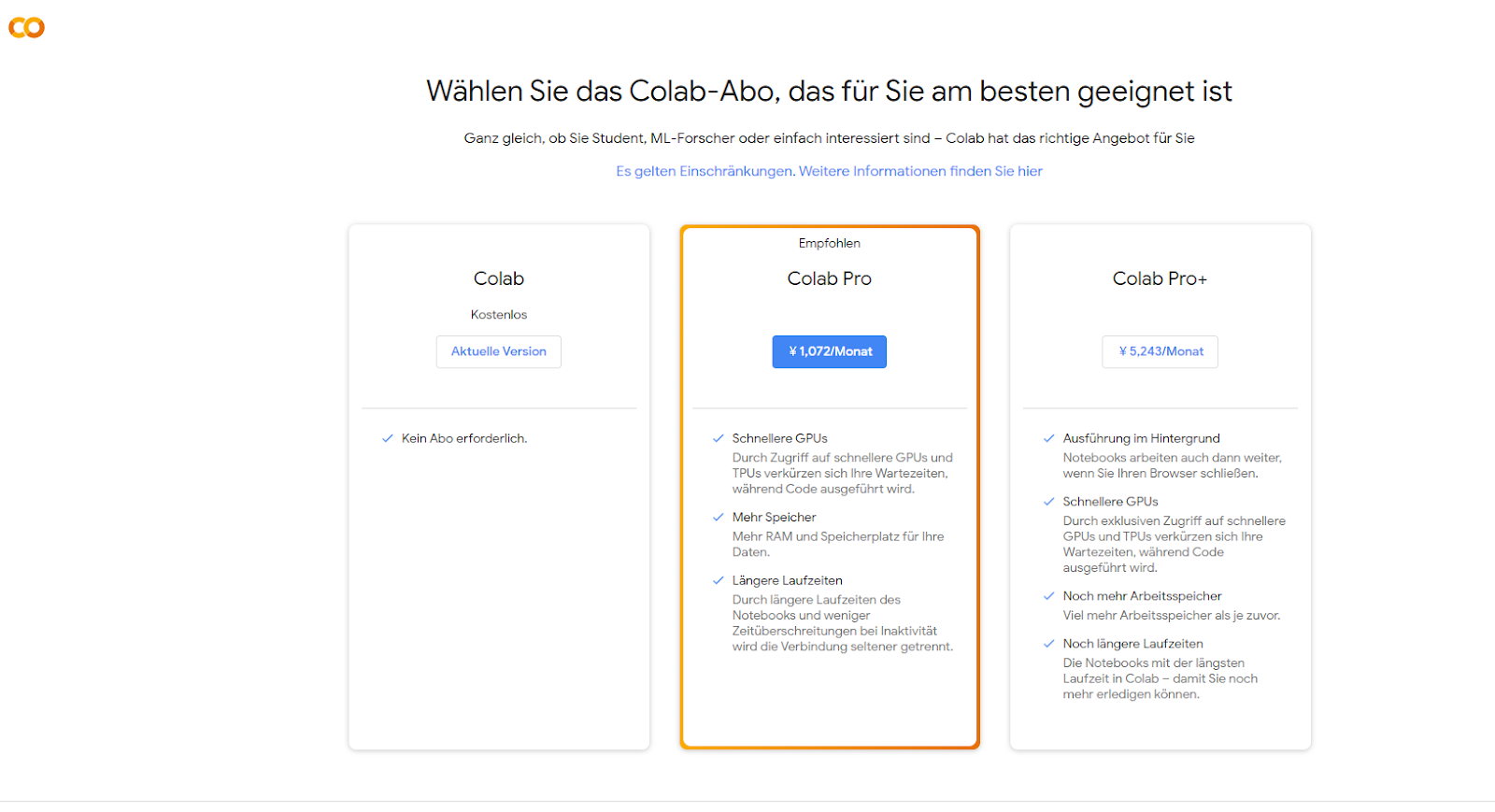

BERTを中心にした、YouTubeの自然言語処理の解説ビデオのまとめです。 BERT 【プロモーション動画】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch? v=fCW7FeZXLRo&list=PLcd5jOpoEDGDzTJHVRwHMT7iMY8XeD1v0 【1-1: イントロダクション】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=8yDtMaTFZ0s 【1-2: コースの概要】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=TOVUrgzX76c 【1-3: 自然言語処理の概要】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=DQn3WfACExI 【1-4: Transformerの概要】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=uJG4ELehq-A 【1-5: BERTの概要】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=RVJLKwOzDmI 【1-6: Google Colaboratoryの使い方】BERTによる自然言語処理を学ぼう! -Attention、TransformerからBERTへとつながるNLP技術- https://www.youtube.com/watch?v=4Qgkbww-tbc&list=PLcd5jOpoEDGDzTJHVRwHMT7iMY8XeD1v0&index= 【2-1